- アンサンブル学習ってなに?

- バギングやブースティング、スタッキングはそれぞれなんなの?

とお悩みではないですか?

本記事では、アンサンブル学習の概要からバギングやブースティング・スタッキングの3種類の手法、行う時の注意点について解説していきます。

アンサンブル学習とは複数のモデルを組み合わせることで予測精度を上げる手法です。

本記事の信頼性

こんな悩みがある方読んで欲しい

- アンサンブル学習ってなに?

- バイアスとバリアンスって?

- バギングやブースティング、スタッキングの違いは?

- アンサンブル学習を行う際の注意点は?

それでは本編です!

月額980円で学べる!

データサイエンスの復習は完ぺきにできていますか?

データサイエンスは勉強する範囲が膨大で、復習に手が回りませんよね。

そんなあなたにおすすめなのが、たった月額980円でサクッと学べる『スタアカ』

数分の動画でビジネスへの活用法も含めて、サクッとデータサイエンスを復習可能。

『何冊も参考書を往復して復習する苦労』とはおさらばです!

サブスクなのでいつでも解約OK。手軽に始めてみませんか?

\月額980円から/

講座が毎月追加されるので今後値上がりする可能性大、今買わなきゃ損するかも!

アンサンブル学習とは

アンサンブル学習とは、複数のモデルを組み合わせてより良い予測を行う手法です。

アンサンブル学習は複数のモデルでまず予測を行います。

そして、それぞれの予測の結果を平均や多数決し、最終的な予測を出すのです。

このように、複数のモデルから予測結果を見ることで、安定した予測性能を確保できます。

補足

それぞれの学習には過学習しないように弱学習器(あまり精度が良くない学習手法)を用いるのが主流です。

必要な事前知識のバイアスとバリアンス

まず、アンサンブル学習を学ぶ上で必要な知識である「バイアス」と「バリアンス」について解説していきます。

バイアスとは予測の値が真の値からどれだけずれているかを表し、バリアンスは訓練データに対して予測値がどれだけばらついているのか(適合しているのか)を表します。

もう少し分かりやすく教えて欲しい......

分かりやすいように、バイアスとバリアンスを過学習と汎化から考えてみると以下のようになります。

- バイアスが高い :汎化している状態(訓練データに対する予測の誤差が大きい)

- バリアンスが高い:過学習している状態(訓練データに対して予測値が適合しすぎている)

汎化している、つまり訓練データに対して予測の誤差が大きい状態ではバイアスが高くなり、過学習の状態ではバリアンスが高くなります。

過学習と汎化がトレードオフ(どちらかが高いとどちらかが低い)の関係であることから、バイアスとバリアンスもトレードオフの関係にあります。

アンサンブル学習を行うとき、バイアスかバリアンスのどちらを調整しているのかを把握できなければ、予測精度が低くなったり過学習してしまったりする可能性があります。

バイアスとバリアンスについて詳しく知りたい方は『バイアスとバリアンスとは?意味やトレードオフ・分解について解説』の記事をご参照ください。

次にアンサンブル学習の種類について解説していきます

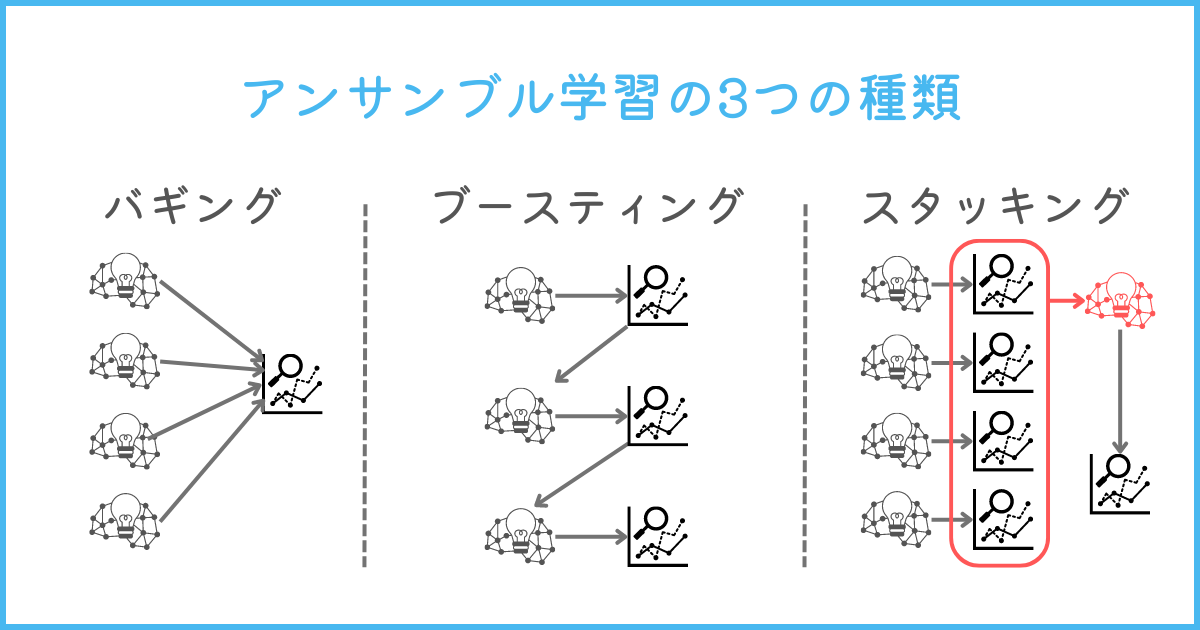

アンサンブル学習の3つの種類

アンサンブル学習には以下の3つの種類があります。

- バギング

- ブースティング

- スタッキング

それぞれの手法が、バイアス、バリアンス、両方を調整するなどの特徴を持っています。

それぞれ解説していきます。

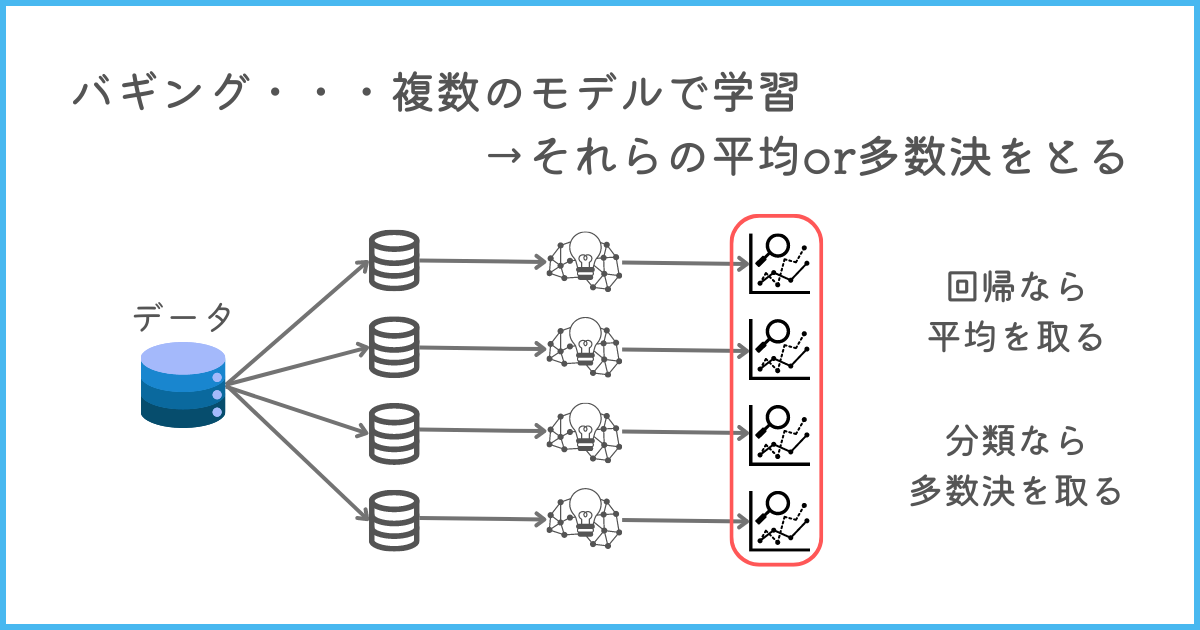

バギング(Bootstrap Aggregating)

バギング(Bootstrap Aggregating)は、同じアルゴリズムを使って複数のモデルで学習させ、それらの予測の平均や多数決を取る手法です。

バギングのメリットは、多くのモデルの平均や多数決を取れる点です。

そのため、極端な予測結果になったモデルがあったとしても、別のモデルと平均を取ることで影響を抑えられます。

なので、バリアンスが高くなること(過学習が起こること)を防げるのです。

バギングは回帰問題に用いるか分類問題に用いるかによって、平均か多数決かが変わります。

- 回帰問題:モデルごとの平均値

- 分類問題:それぞれのモデルの多数決

回帰問題は出力される予測が数値なので、それぞれのモデルで算出した予測を平均を取ります。

そのため、回帰問題の解が極端なモデルがあっても、平均を取ることで予測が確かな数値になるのです。

また、分類問題はどのクラスに分類するのかという問題であるため、多数決を取ります。

例えば、5つのモデルがそれぞれ「A,A,A,B,B」とクラスを予測した時、バギングを行うことでAであると多数決で導けます。

さらに、バギングは同時に複数のモデルを学習できるため、計算時間があまりかからない点がメリットです。

補足

代表的な手法として、決定木を用いたバギングであるランダムフォレストなどがあります。

決定木はバリアンスが高く(過学習になりやすく)、弱学習器であることから、バギングの学習器として使われるのです。

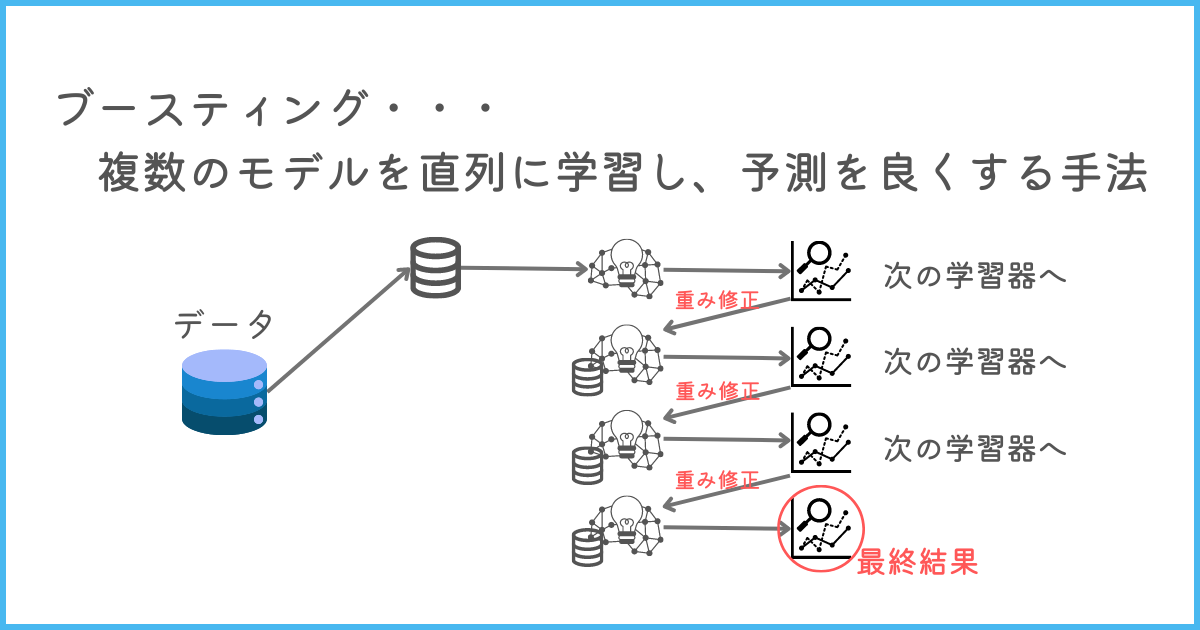

ブースティング

ブースティング(Boosting)は、複数の弱学習器(予測性能が低いモデル)を直列に組み合わせて、モデルの誤差を修正していく手法です。

1つ目の学習したモデルの誤差を、次のモデルの学習で補正するように学習するということを続ける方法を取ります。

少しずつ誤差を減らしていくので、訓練データに対する予測精度を上げていけるのです。

ブースティングは、バイアスが高い状態(汎化しすぎている状態)を下げる効果があります。

モデルとして弱学習器を使うのはなんで?

精度の高いモデルを直列に繋いでしまうと、精度が良くなりすぎて過学習の状態になるためです。

なので、予測精度の高くない弱学習器を採用しましょう。

有名なブースティング手法として、AdaBoostや勾配ブースティング、XGBoost、LightGBMなどがあります。

これらの手法を用いることで、予測性能を向上させるように学習器を組み合わせられます。

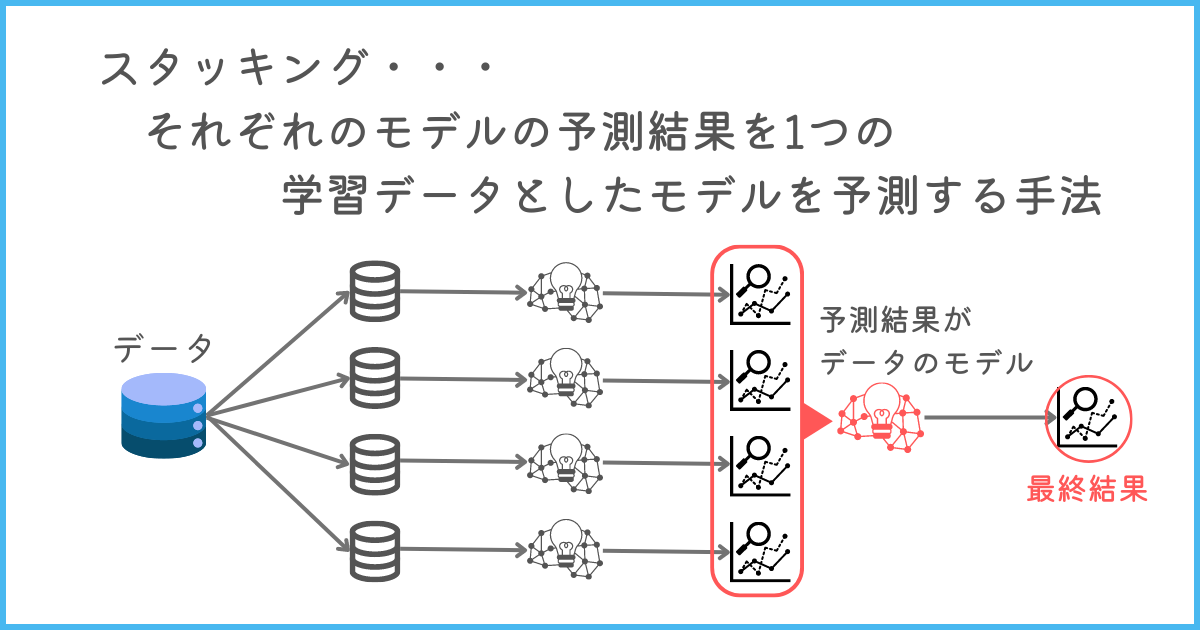

スタッキング

スタッキングとは複数の異なるモデルの予測結果を1つの学習データとして最終的なモデルを作成し予測する手法です。

スタッキングの最大のメリットは、モデルの多様性を確保できる点です。

スタッキングでは、アルゴリズムの異なるモデルを組み合わせます。

そのため、それぞれのモデルの弱点を補うことや安定した予測結果が得られるのです。

しかし、計算コストがかかる点や採用するモデルによって予測性能が大きく変わってしまうことが難点としてあります。

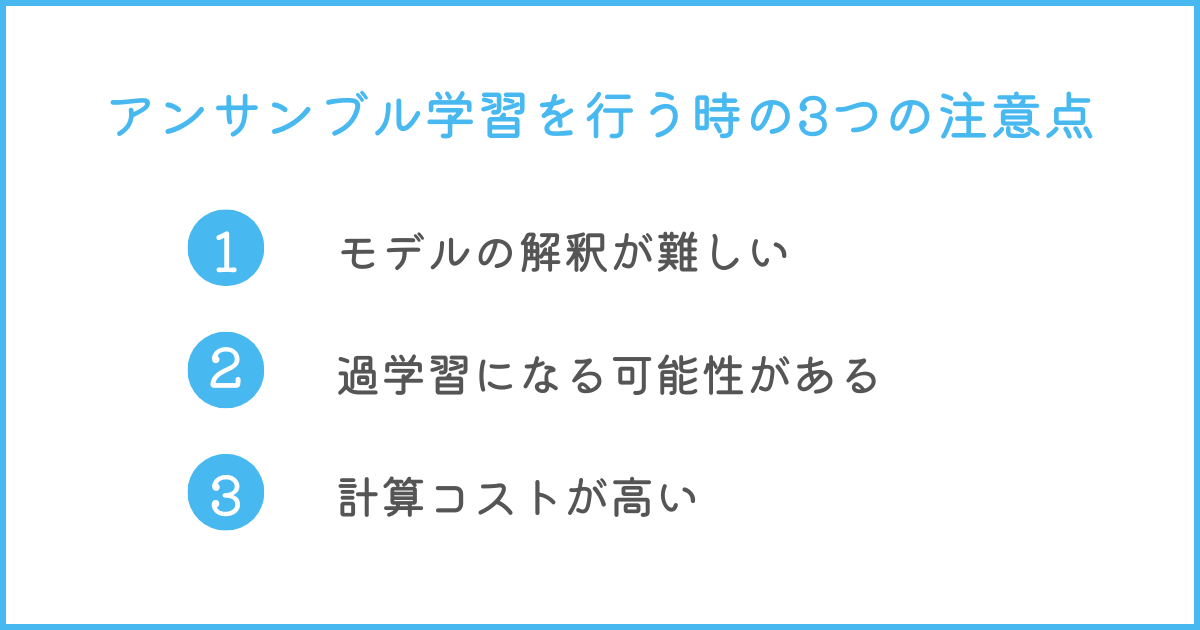

アンサンブル学習を行う時の3つの注意点

アンサンブル学習は予測精度を上げられる良い手法ですが、注意点があります。

注意すべき点は以下の3つです。

- モデルの解釈が難しい

- 過学習になる可能性がある

- 計算コストが高い

アンサンブル学習は予測精度を上げられますが、使いどころが限られます。

それぞれ解説していきます。

モデルの解釈が難しい

アンサンブル学習は、複数のモデルを組み合わせて最終的な予測結果を出すため、モデルの解釈が難しくなります。

ビジネスの分析では、最終的な予測結果より、その要因がどのようになっているのかが重要です。

そのため、予測するモデルは要因などを分析できるまで簡単にしなくてはなりません。

アンサンブル学習は予測の背景まで確認しなくてよい時に用いることがおすすめです。

また、もし説明しなければならない場合、どこまで簡単なアンサンブル学習なら説明可能なのかを見極めましょう。

過学習になる可能性がある

アンサンブル学習はモデルを組み合わせることから、過学習になる可能性が高いです。

アンサンブル学習に用いるモデルが既に複雑であった場合、それらを組み合わせるとさらに複雑になってしまいます。

そのため、アンサンブル学習で用いるモデルは予測精度がそこまで高くない弱学習器が用いられるのです。

また、モデル同士の相関・依存関係が強いと、データに過剰に適合してしまう事があるため注意してください。

過学習の詳しい防ぎ方は『過学習(Overfitting)とは?起こる原因から見分け方・対策方法までわかりやすく解説!』の記事をご参照ください。

計算コストが高い

アンサンブル学習は計算コストが大きくなる傾向にあります。

なぜなら、複数のモデルを学習する必要があるためです。

大量のデータからアンサンブル学習でモデルを作成する場合や変数が多い場合は、計算コストが大きくなります。

また、ブースティングは直列にモデルの学習を進めていくため、バギングに比べて計算コストが大きいです。

もしアンサンブル学習を行う場合は、計算コストに余裕を持つか効率的な計算コストの戦略を立てることをおすすめします。

まとめ

アンサンブル学習は複数のモデルを組み合わせることで、より高い予測性能にする手法です。

アンサンブル学習で大切な「バイアス」と「バリアンス」は以下のように解釈を行うと分かりやすくなります。

- バイアスが高い :汎化している状態(訓練データに対する予測の誤差が大きい)

- バリアンスが高い:過学習している状態(訓練データに対して予測値が適合しすぎている)

アンサンブル学習だけに限らず、モデルを作成する時はバイアスとバリアンスの関係性、トレードオフを意識しておきましょう。

アンサンブル学習には大きく3種類あります。

- バギング

- ブースティング

- スタッキング

バギングはバリアンスを下げ、ブースティングはバイアスを下げる手法です。

スタッキングは、学習したそれぞれモデルの予測を特徴量としてさらに学習を進めるため、バイアスもバリアンスも調整が効きやすい手法になります。

しかし、アンサンブル学習を行う時は3つの注意点を把握したうえで行うことをおすすめします。

- モデルの解釈が難しい

- 過学習になる可能性がある

- 計算コストが高い

アンサンブル学習は複数のモデルを組み合わせるため、モデルの解釈が極めて難しいです。

さらに、何も考えずにアンサンブル学習を行えば過学習になる可能性があります。

また、モデルを複数学習することから計算コストも高くなります。

ビジネスにアンサンブル学習を用いる際は

これらの注意点を踏まえて実装するようにしましょう!

- 機械学習の勉強がなかなか上手く進まない...

- 勉強していても全体像が見えてこない...

- 本当にデータサイエンティストになれるのかな...

と不安に感じてはいませんか?

そんな悩みをまるっと解決してくれるサービスが『スタアカ』です。

僕も利用している『スタアカ』のライトプランは月額980円で動画見放題でコスパ最強です。

「勉強の道しるべが欲しい!」「学習を効率的に進めたい」という方にはこの上ないサブスクです。

データサイエンスを学びたい方に最強のサブスク『スタアカ』を気軽に始めてみませんか?

\月額たった980円!/

講座が毎月追加されるので今後値上がりする可能性大、今が買いどき!

「ちょっとでも興味がある」という方は、受講した感想も載せている記事もあわせてどうぞ。